把「大模型」塞进手机里,究竟有多难?

苹果找了一条新思路。

能装进口袋的AppleGPT,它可能比你想象得更早成为现实。

据科技媒体MacRumors报道,苹果公司的AI研究人员在近期发布的一篇研究论文里,提到一种创新的闪存技术,该技术可能是为了探索“在有限的内存中运行大语言模型”(论文地址:2312.11514.pdf (arxiv.org))。

把AI大模型装进手机里,并不是什么稀奇的事情。自今年下半年起,国内手机厂商们纷纷透露自家大模型的消息,并表示未来的旗舰机型都会接入大模型。

不仅是手机,汽车、PC、平板甚至是学习机,都尝试将大模型嵌入其中。而这些大模型的规模也,从十亿级到百亿级,甚至千亿级。

不过发布会的演示虽多,实际测试下来真正惊艳的其实并不多。

例如一些所谓的手机大模型产品,无论是回答问题、生成一段文本或是图画,体验感都远远不及网页侧的GPT产品。

手机AI大模型,难在硬件

早在ChatGPT诞生前,智能手机上的语音助手们,其实就已经拥有人机交互、实时语音交流等能力。例如Siri、小爱、小艺等产品,它们在用户与进行对话后,即可完成一些简单操作指令。

可只要问题稍微复杂一点,这些语音助手就会变成“人工智障”,无法理解用户的真实意图。

此外,这些语音助手的功能很单一,无论是专注做语音功能,还是打造成一款全能性的应用,使用反馈都很一般。

随着大模型产品的成熟,AI的效率得到进化,原本“不聪明”的语音助手们终于有望像ChatGPT回答复杂的问题,大大提高智能手机的可玩性——这本是手机厂商们急于落地AI大模型技术的初衷。

而从实际体验来看,手机大模型应用的体验感并没有想象中惊艳,各种功能都不及网页侧。

我们以小米大模型为例,在演讲中,雷军表示,小米的突破方向是轻量化和本地部署,也就是所谓“端侧大模型”。

而想要运行起来,还少不了本地处理器。

在小米发布自研大模型之前,高通推出了新一代移动平台骁龙8 Gen 3。该处理器除了提升各方面性能以外,最重要的是引入了全新的Hexagon NPU处理器,将AI总算力推到了73TOPS,支持终端侧AI及生成式AI性能。

按高通表示,新处理器在终端设备上首次实现了运行100亿参数的模型,并且针对70亿参数LLM每秒能够生成20个token——这意味着目前的各种主流LLM都可以在手机端正常运行。

但实际情况是,小米AI大模型MiLM推出了6B(64亿)参数,1.3B(13亿)参数两个版本,只有更小巧的1.3B参数版本被塞进手机。

在采访国内大模型初创公司智子引擎时,他们提出过一个思路——针对芯片硬件侧,不管是大模型的训练和推理,除了要考虑算力的问题外,还要关注数据处理的存储量的问题。

像 ChatGPT 和Claude 这样基于LLM的聊天机器人,其实非常耗费数据和内存,通常需要大量内存才能运行,这对于 iPhone 等内存容量有限的设备来说是一个挑战。

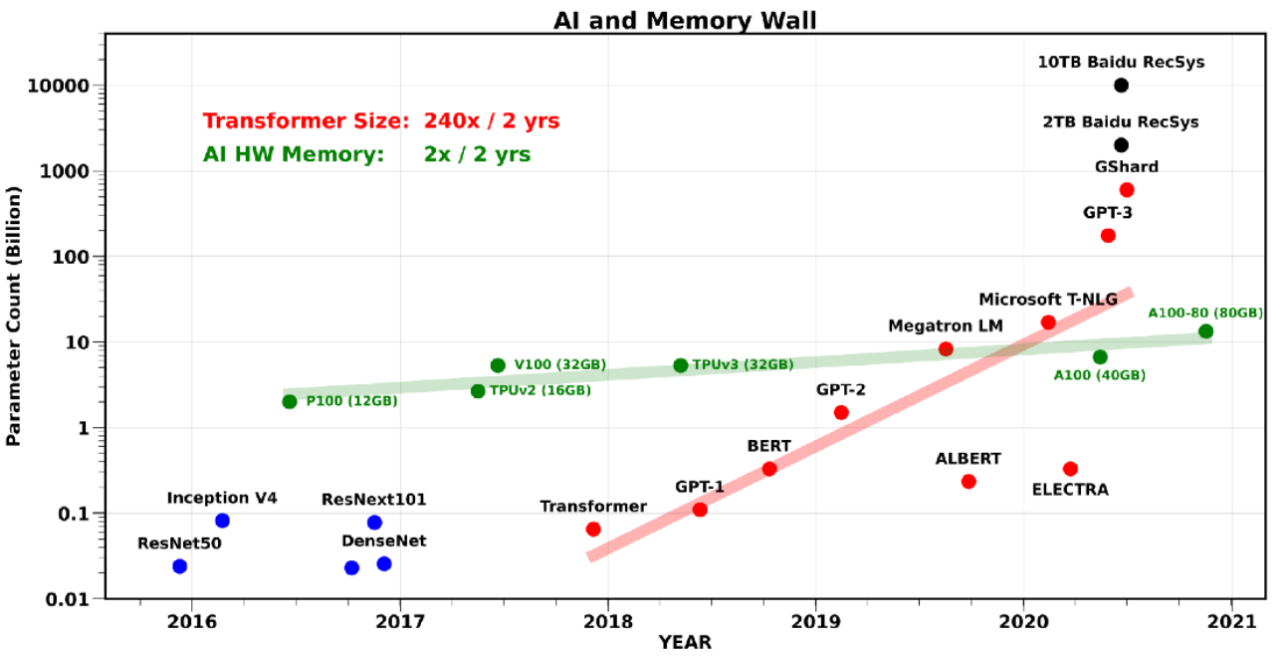

而在AI 模型不断膨胀的同时,内存厂商的增长却当前的需求,造成了“内存墙”问题。

因此在苹果AI研究人员的论文里,作者别出心裁地提出针对闪存进行改进,从而绕过限制,从而移动设备支持运行超出自身内存规模的模型。

至于解决方法,一个是Windowing (窗口化),通过重用先前激活的神经元来战略性地减少数据传输,

第二个是Row-Column Bundling(行列捆绑),根据闪存的顺序数据访问强度量身定制,增加了从闪存读取的数据块的大小。

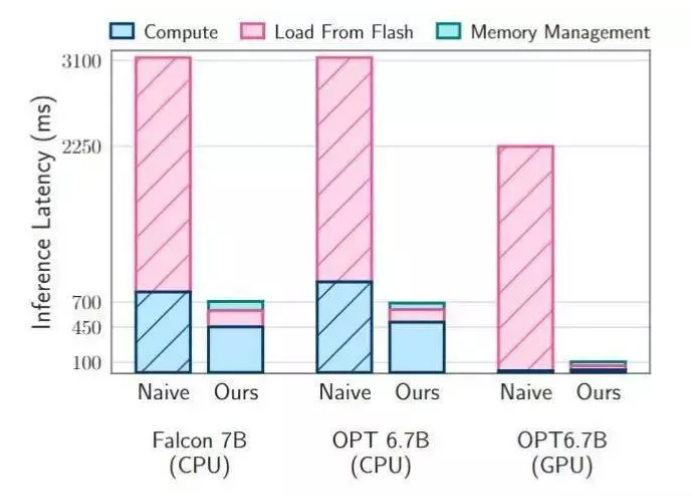

由于这项技术还停留在论文层面,我们只能从轮数据上得到反馈。

数据显示,测试LLM的推理速度在Apple M1 Max CPU上提高了4-5倍,在GPU上提高了20-25倍,效果还是非常明显。

最后,论文作者总结到:“这一突破对于在资源有限的环境中部署先进的LLM尤为重要,扩大了它们的适用性和可访问性。

对于消费者来说,在解决了内存问题后,就花费更少体验更强的AI应用,手机厂商们也不用为模型参数犯愁。

当然,手机AI大模型面临的难题不仅是内存,还有老生常谈的“功耗问题”,这一点也是未来手机处理器厂商需要重点考虑的问题。

改做小模型,可行吗?

在解决硬件问题之前,还有一些手机厂商采用云端大模型接入的方式。

虽然这种云端协同的方式可以让手机接入更大参数的大模型,但用户每一次使用应用时都会产生费用,而当国内所有用户使用大模型应用的话,一年下来也是一笔不少的开支。

因此在这两种路径外,一些AI公司开始探索起小模型(SLM)的潜力。

例如微软,目前在生成式AI战略上出现了180度大转变,推出多款小模型。

就在本月,微软发布了27亿参数规模的小语言模型Phi-2,经研究人员测试,该模型在参数规模小于130亿的模型中,展示了最先进性能。

以高质量的“小数据”挑战“大模型”,这是小模型的特点之一。除此以外,因为参数规模足够小,Phi-2可以在笔记本电脑、手机等移动设备上运行。

随着越来越多的厂商开始探索在手机等移动设备上部署大模型,微软的小模型产品可以用凭借更加出色的性能抢先占领移动市场。

除了微软以外,一些初创AI公司也选择从小模型入局。

例如号称欧洲版OpenAI的Mistral AI,他们推出的开源模型Mistral 7B,就是一款非常有特点的小模型,仅仅用7B模型就达到了大部分大模型的水平。

而他们其实更看到B端企业客户的需求,在保护企业的私有数据不被泄露和利用提前下,让小模型成为更实用的企业版方案,这也非常符合欧洲当地企业的特点。

不过总的来说,小模型与大模型算是两种不同类型的产品,都有各自的价值,不存在取代关系。

或许在未来的移动设备上,大模型和小模型都能有所作为。但就目前来看,“手机AI大模型”还要很多难题亟待解决。

最后,记得关注微信公众号:镁客网(im2maker),更多干货在等你!

硬科技产业媒体

关注技术驱动创新

MacPC智能手机水电脑

MacPC智能手机水电脑

微信ID:im2maker

微信ID:im2maker 长按识别二维码关注

长按识别二维码关注