当AI成为你的医生……

以下6点,是对AI医生的基本诉求。

“大数据和人工智能极大提高了我们对新冠肺炎的诊断、预测和治疗水平。”钟南山此前如是说。

至于怎么提高的,他也举了几个案例,比如通过1000多个全国新冠肺炎患者的大数据了解到潜伏期、临床症状,为新冠肺炎早期症状鉴别提供帮助;又比如根据大数据生成新冠肺炎疫情预测模型,为政策制定提供重要依据……

不得不承认,大数据和AI对医疗产业的助力是有实际成效的,这也难怪谷歌、IBM、腾讯、百度和阿里等科技巨头也创企蜂拥而上。但是,金无足赤、人无完人,AI落地医疗有时候也会犯错。

也因此,WHO找来了20位专家,并花费2年时间为AI量身定制了一套“医生准则”。

WHO:AI落地健康领域,要遵循6大关键原则

WHO在报告中强调了AI在健康领域的前景,以及帮助医生治疗病人的潜力,并指出有几十种潜在的方式可以将人工智能应用于医疗保健。

但是,一旦AI没有被仔细开发和实施,最好的结果是无法达到预期效果,最差的结果这就是造成伤害了。

因此,WHO出手为AI在健康领域的落地制定了指南,其中要点原则有6个:

1.保护自主权——人类应该对所有健康决定进行监督并拥有最终决定权。这些决定不应该完全由机器做出,医生应该能够在任何时候推翻它们。未经同意,人工智能不应该被用来指导某人的医疗护理,而且他们的数据应该受到保护;

2.促进人类安全——开发人员应持续监测任何人工智能工具,以确保它们按规定工作,不会造成伤害;

3.确保透明度——开发者应该公布有关人工智能工具设计的信息。对这些系统的一个经常性批评是,它们是 "黑盒子",研究人员和医生很难知道它们是如何做出决定的。世卫组织希望看到足够的透明度,以便用户和监管机构能够充分审计和理解它们;

4.培养问责制——当人工智能技术出现问题时,比如工具做出的决定导致病人受到伤害时,应该有机制来确定谁应该负责(比如制造商和临床用户);

5.确保公平——要确保工具有多种语言版本,并在不同的数据集上进行训练。在过去的几年里,对普通健康算法的仔细审查发现,一些算法中存在种族偏见;

6.推广可持续发展的人工智能——开发者应该能够定期更新他们的工具,如果一个工具看起来没有效果,机构应该有办法进行调整。机构或公司也应该只引进可以修复的工具,即使是在资源不足的卫生系统。

黑盒子、开错药、数据隐私……6点原则背后AI的另一面

在报告中,WHO明确表示,希望这6项原则能够成为政府、开发商和监管机构处理AI的技术。但是当我们反过来看,就会发现,不少情况早已经出现。

比如自主权,该问题是科技公司利用AI赋能健康产业中最常发生的隐患。比如谷歌母公司Alphabet旗下的DeepMind就曾发生一件“丑闻”,并因此在英国被判违法:

2016年,英国医疗服务体系(NHS)在与DeepMind的一项医学实验合作中,向后者提供了约160万名患者的详细资料,用于开发和完善一个急性肾损伤诊断和检测系统。但是,他们的一切操作是在患者不知道的前提下进行的,且也没有告知患者医疗记录数据的使用方式。

最终在2017年,英国最高隐私保护监管部门裁定,DeepMind的该项医学实验违反了英国的数据保护法。

需要注意的是,虽然丑闻被曝出,但是谷歌方面在之后的几年内并没有停止这种侵犯用户自主权的行为,包括在2017年,被指控通过芝加哥大学医学中心不当访问数十万份医疗记录,以及在2018年被曝出的“夜莺计划”——医生和患者毫不知情的情况下,在21个州秘密收集数百万份包括医生诊断、住院记录、姓名和出生日期等数据的患者病历及健康历史,且有部分谷歌员工有权访问这些敏感数据。

而除了自主权,站在患者的角度,他们还担心安全问题,包括诊断和检测过程的安全,以及用药的安全。

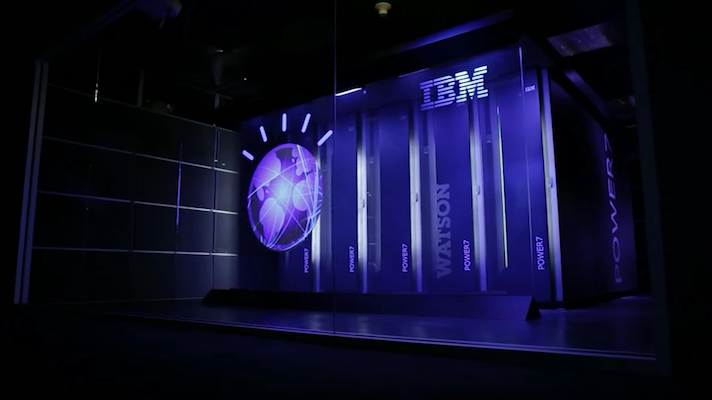

其实,这并不是无来由的担心,因为这一情况已经在现实生活中发生了。就在2018年,此时,IBM还在如火如荼的基于AI系统Watson发展自己的医疗业务,但是Watson却被曝出为一位有严重出血可能的肺癌患者,开出了容易导致大出血的药物。

当然,开错药的情况也有在人类医生身上发生过,但正如第三点原则中提到的“黑盒子”,AI医生开药的逻辑是基于过往海量病历数据训练出来的,但是具体过程并不会展现给人类医生,而对于患者而言,这显然会带来一种“不安全感”。

此外,虽然AI医疗赛道中鲜少被报道,但在其他像智能语音助手等赛道中,如同WHO所担心的那样,诸如种族歧视、性别歧视等不可控因素已经出现。

不可否认,AI的作用是潜力无限的,包括用AI来筛选检测病灶、帮助患者监测自己身体的各项数据、追踪新冠等疫情的爆发等等。但当我们从理论回到现实,即便没有WHO的6项原则,即便是头部的公司,在利用AI赋能健康产业这条道路上,也是走得磕磕绊绊。

在AI医疗方向,科技公司们正节节败退

追溯科技公司在AI医疗赛道上的败退,最先为人熟知的是曾经的领头羊IBM。

IBM旗下的Watson Health部门,主要利用AI帮助医院、保险公司和制药商管理数据、辅助诊断。

但在这之后,6年时间年收入10亿、8年内25个代表合作项目仅有5个推出产品等事实狠狠“扇醒”了IBM,再加上前面提到的开错药等“丑闻”,Watson Health在之后几年内的存在感逐渐减弱,最终在今年2月份,IBM宣布将对外出售该部门。一代创新项目“黯然落幕”。

而说到与IBM在AI医疗赛道称得上并肩前行的公司和项目,还有谷歌和它的Google Health。与Watson Health一样,Google Health也是背靠科技巨头,自诞生起就有着无数资源,但也挡不住它与Watson Health类似的命运。

3年前,谷歌成立Google Health,合并了DeepMind旗下的健康部门DeepMind Health和负责推进“Streams”医疗APP的团队,同时还从盖辛格医疗中心挖来了David Feinberg就任主管,后者是全美最好的成人专科医院之一。

一切都是那么的美好,但现实情况却是,3年过去了,这一业务依旧处于亏损状态,而主力推广的糖尿病视网膜病变筛查业务,也因为检测照片不达算法检测要求而导致准确率不如预期,且极度依赖网络速率的特性也让这一产品落地后在效率上大打折扣。

现如今,Google Health在6月份被曝出将进行大规模裁员重组,并且做好了重组后依旧不赚钱的准备。

可以看到,不管是IBM,还是谷歌,他们在健康业务上的症结主要在于两点,分别是AI系统落地后效果不如预期,以及不赚钱。

事实上,这两点对国内AI医疗公司的阻碍也同样适用。比如盈利问题,如今已有多家公司因为盈利难等问题正面临资金断链、业务收缩或重组等现实问题。

而更为值得令人深思的是,AI医疗的可行与可信。

针对这一点,AI大牛吴恩达曾在去年这样说,医疗领域AI研究的算法难以投入到生产,因为以部分数据训练出的模型,难以泛化到其他情况。

这句话揭露的是当前AI医疗算法模型过程中数据规模、规范性等方面的问题。

比如谷歌,虽然其健康部门还没有落到与IBM Watson一样的境遇,且也已经做好了不赚钱的准备。但是,成熟技术与盈利之间终究存在着千丝万缕的牵连。盈利问题到最后终究会被再次提出,而这需要以技术成熟并落地为前提。

最后,记得关注微信公众号:镁客网(im2maker),更多干货在等你!

硬科技产业媒体

关注技术驱动创新

创新开发者用户腾讯隐私

创新开发者用户腾讯隐私

微信ID:im2maker

微信ID:im2maker 长按识别二维码关注

长按识别二维码关注